/intro til SPSS

Her finner du tips og triks for å komme i gang med å bruke SPSS

Den første gangen man åpner SPSS kan det virke utfordrende å finne frem i programmet. Den første siden man møter kan minne om ExCel, men uten muligheten til å legge inn formler og lignende. I stedet må man navigere ulike menyer for å finne frem til analysene man ønsker å gjøre. På denne siden kan du bli kjent med brukergrensesnittet til SPSS og lære hvordan du gjør deg klar til å bruke programmet for første gang. I eksemplene på denne siden vil vi bruke SPSS versjon 27, som er den nyeste utgaven av programmet. I eksemplene vil vi bruke ulike art i øvingsdatasettet som du kan laste ned under Maler.

Åpne datasett

Det første man må gjøre før enhver analyse er å åpne et datasett i SPSS. For å gjøre dette trenger vi enten 1) en .sav fil som er filformatet som kan åpnes direkte i SPSS, eller 2) en ExCel-fil som inneholder datasettet vi ønsker å analysere. I dette eksempelet skal vi bruke en ExCel-fil og antar da at vi allerede har datasettet vårt ferdig plottet og ryddet. Denne prosessen kan du lære mer om på siden om ExCel.

Når vi er klar til å starte, åpner vi programmet og blir møtt av et tomt regneark. Her skal vi få inn våre variabler slik at vinduet ligner på ExCel-filen vår. Det finnes to måter å gjøre dette på: 1) ved å kopiere kolonnene fra ExCel, eller 2) å åpne ExCel-filen i SPSS. Å kopiere og lime fungerer og er veldig enkelt, men det gjør at man etterpå må definere kolonnene sine da overskriften ikke kan limes inn direkte. I dette eksempelet går vi for å bruke den andre funksjonen som er å åpne filen i SPSS. I dette eksempelet skal vi åpne Ark 2 fra øvingsdatasettet som du kan laste ned under Maler.

Vi starter ved å trykke på "File > Open > Data". Snarveien til samme vindu er "Ctrl + O" i Windows eller "Command + O" på Mac. Nå får vi opp et filutforskervindo som heter "Open data". Her kan vi bla gjennom filene våre og finne den vi ønsker å åpne. Siden det er en ExCel-fil vi skal åpne, vil vi ikke finne noe når vi har letet oss frem til riktig mappe. Dette er fordi programmet leter etter SPSS-filer av typen .sav. Vi blir derfor nødt til å gå i menyen neders og velge den filtypen vi leter etter, nemlig ExCel (.xls, .xlsx, eller .xlsm). Etter å ha valgt riktig alternativ her vil vi få opp filen vi leter etter og kan dobbeltklikke på denne eller velge filen og trykke på "Open".

Nå vil vi filen gjøres klar til åpning, men først får vi noen valgalternativer. I dette vinduet trenger vi som regel bare å endre en ting og det er "Worksheet". Ofte vil denne være satt på riktig ark, men siden vi i dette alternativet skal åpne Ark 2 i øvingsdatasettet, må vi endre på denne. Dette gjør vi enkelt ved å åpne menyen og finne det arket vi skal bruke. Dersom du åpner en ExCel-fil med bare ett ark, vil det ikke være nødvendig å endre noe her. De andre alternative handler om hvor mye av datasettet på arket som skal føres inn i SPSS. I de fleste tilfeller vil vi analysere hele datasettet og lar derfor de resterende alternativene stå som de er. Når vi trykker på "OK" vil datasettet åpnes i SPSS og vi er klare til å gå videre med a definere datatyper og gjøre oss kjent med datasettet før vi begynner på analysene.

Definere datatyper

Før vi begynner å analysere dataene våre, bør vi sjekke at de er definert som riktig datatype. Du kan lese mer om datatyper her. Kort fortalt skiller SPSS mellom 3 typer: scale, ordinal og nominal. Scale er kontinuerlige data, som for eksempel høyde, vekt eller temperatur, hvor man kan ha verdier som 1.75 meter, 70.5 kg, eller 22.3 grader Celsius. Du kan teoretisk sett bryte ned kontinuerlige data i så små enheter du ønsker, som 1.755 meter eller 22.334 grader Celsius. Ordinale data er kategoriske data som har en naturlig rekkefølge eller rangering, men hvor avstanden mellom kategoriene ikke nødvendigvis er kjent eller meningsfull. Et eksempel på ordinale data kan være en utdanningsnivå hvor vi vet rekkefølgen på gradene, men avstanden mellom hvert alternativ varierer. Nominale data er også kategoriske data, men i motsetning til ordinale data har de ingen naturlig rekkefølge eller rangering. Nominale data brukes til å navngi eller kategorisere dataene våre. Eksempler kan være kjønn eller favorittfarger. Her er det ingen iboende rekkefølge eller rangering mellom kategoriene, men dataene kan likevel hjelpe oss å skille mellom kategorier.

Så snart vi åpner et datasett i SPSS, vil programmet definere datatypene for oss. De fleste vil som regel automatisk bli korrekte, men noen ganger bommer programmet. Dette er spesielt når det forsøker å skille mellom nominale og ordinale data. For å undersøke om data er korrekt definert, kan vi trykke på "Variable View" helt neders i hovedvinduet til SPSS. Da får vi opp en oversikt over datamaterialet vårt, men sortert nedover i stedet for bortover, og uten verdier. I stedet får vi en oversikt over hvordan data vil se ut når vi skal sette igang med analysene. Som du kan se under, får vi opp en rekke kolonner. I eksempelet under ser vi variable view for Ark 2 i øvingsdatasettet.

Før vi ser på datatyper, kan vi gjøre et par mindre justeringer for å få datasettet vårt til å se ryddigere ut og bli lettere å håndtere når vi skal analysere det. Vi ser helt til venstre under "Name" at kolonnenavnene fra ExCel har blitt med oss inn i SPSS. Disse kan noen ganger være beskrivende, men samtidig være lange og inneholde mer informasjon enn vi trenger for å analysere de. Her har vi muligheten til å legge inn et kallenavn under "Label" slik at variablene blir enklere å bla gjennom når vi skal velge de for analysene. Legg også merke til at vi har noen variabler (V8 - V12) som ikke gir mening. Disse stammer fra kolonner i ExCel hvor vi kanskje har endret formatet (f.eks. midtstilt data) uten å legge inn noe informasjon. Disse kan enkelt slettes i "Data View" (eller høyreklikke i "Variable View" og velge "clear") slik at de ikke forstyrrer oss når vi skal velge kolonner for analyser. Videre kan vi se på "Decimals". Disse vil ofte ligge mellom 0 og 2, men noen ganger, særlig hvis man har laget kolonnene ved å bruke formler i ExCel, kan de ha over 10 desimaler. Dette vil gjøre datasettet mindre visuelt oversiktlig, så vi kan endre disse til 1 eller 2. Merk at tallet vil ikke endre seg, vi endrer bare hvor mange desimaler vi kan se. Vi har også muligheten til å midtstille dataene under "Align" dersom det er ønskelig.

Når alt ser ut slik vi vil ha det kan vi se på datatyper. Disse finer vi under "Measure" hvor vi har 3 valg: scale, nominal og ordinal. Her kan vi gå gjennom hele datasettet slik at vi blir godt kjent med dataene og får tydelige eksempler på hvordan vi definerer datatyper. Den første variabelen er "Person" hvor vi har deltakerne våre med nummer fra 1 til 40. Denne har blitt satt som scale, men vi vet at dette bare er kategoriske data, så det må være enten nominal eller ordinal. Vi vet også at det ikke er bedre å være person 1 enn person 2, siden nummerne er tilfeldig tildelt, så vi vet at disse ikke er ordinal. Da gjenstår bare nominal. Vi trykker på "Scale" på raden bak "Person" og velger "Nominal" og datatypen er nå riktig definert.

De neste variablene er diastolsk blodtrykk. Disse verdiene kan være hvor som helst innenfor en gitt range (f.eks. mellom 70 og 110), noen verdier er "bedre" enn andre, og de kan brytes ned i mindre verdier (f.eks. 80.05 eller 100.4547). Det betyr at disse skal være "Scale" og vi ser at SPSS allerede har definert disse riktig for oss. Videre finner vi kroppsvekt. Denne har også blitt satt som "Scale". Siden verdiene under "Vekt" forteller oss om noen veier mer eller mindre enn andre og vi vet nøyaktig hvor langt det er mellom hvert kilo, kan vi si oss enige med denne definisjonen.

Obs: på grunn av skillet mellom parametriske og ikke-parametriske tester som tar utgangspunkt i både datatype og normalfordeling, hender det at mange tror at verdier som ikke er normalfordelte, ikke er kontinuerlige. Dette stemmer ikke. Kontinuerlige data vil ofte være normalfordelte, men ikke alltid. Nominale og ordinale data vil som regel ikke være normalfordelte, men ikke aldri. Vi definerer datatypene ut ifra informasjonen tallene inneholder. Fremtidige tester for normalfordeling og analyser har ikke mulighet til å endre disse.

Vi endte altså opp med 1 nominal variabel, mens resten var kontinuerlige. Dette er et vanlig resultat da verdier vi ønsker å gjøre statistiske analyser på ofte vil være kontinuerlige. I andre datasett støter man gjerne på flere forekomster av andre datatyper. I Ark 1 i øvingsdatasettet har vi for eksempel en variabel som heter "Løpeerfaring" og er delt inn i 3 nivåer fra nybegynner til ekspert. Dette er et eksempel på ordinale data siden de ligner på nominale, men har en rekkefølge (ekspert er "bedre" enn nybegynner). Samtidig er det ikke en bestemt avstand mellom disse da det kan ta ett eller mange år å gå fra et nivå til det neste. Man kan heller ikke dele opp verdiene og si at noen er på nivå 2.4. Dette gjør at variabelen ikke er kontinuerlig selv om vi har en bestemt rekkefølge på verdiene. Et annet eksempel på datasett med færre "Scale"-variabler kan være spørreskjema. Her samler vi ofte inn en kombinasjon av nominale data (kjønn, bosted, yrke, etc.) og ordinale data som for eksempel via skalaer med grad av enighet.

Bli kjent med datasettet

Etter at vi har åpnet datasettet og definert datatype er vi klare til å bli bedre kjent med dataene våre. Dette kan vi blant annet gjøre ved å gjennomføre deskriptive analyser og undersøke normalfordeling. I dette eksempelet skal vi bruke Ark 1 i øvingsdatasettet og se på tre enkle måter å visualisere dataene våre.

Den første metoden er å benytte Scatter-plots. Dette er figurer som viser oss to variabler og hvordan de henger sammen eller korrelerer. For å lage en scatter-plot, trykker vi på "Graphs > Legacy Dialogs > Scatter/Dot" og velger "Simple Scatter" i alternativene som dukker opp. I dette eksempelet starter vi med å se på høyde og skostørrelse. Man kan ta hvilke som helst variabler, men dersom man forventer en sammenheng mellom de man velger, kan det være lettere å identifisere eventuelle uteliggere. Vinduet vårt blir så seende slik ut. Vi trenger ikke å gjøre flere justeringer her, så vi trykker på "OK" for å lage scatter-plot.

Resultatet er en visuell fremstilling av de to variablene med skostørrelse på x-aksen og høyde på y-aksen. I dette tilfellet ser vi at det er en tydelig sammenheng mellom de to, slik at hver person havner lenger oppe (høyere) jo lenger til høyre de er (større sko). I dette tilfeller kan vi ikke visuelt identifisere noen uteliggere, men dersom vi for eksempel hadde observert et datapunkt med skostørrelse 40 og høyde på 190 cm, ville dette tydelig ha skilt seg ut fra det resterende datasettet (se den røde prikken som eksempel). Dette eksempelet ville skilt seg ut, men fortsatt kunne vært reelt. I andre tilfeller kunne vi ha funnet noen med skostørrelse 4 eller høyde på 1999 cm. Vi måtte da ha tatt en vurdering på om vi ville ha slettet disse åpenbart feile dataene, eller redigert de til skostørrelse 40 og høyde 199 cm dersom vi var sikre nok på at dette var den reelle målingen.

I det neste eksempelet skal vi bruke en fremgangsmåte som ligner på den vi bruker for å undersøke normalfordeling. Vi skal lage box-plots og histogram, noe vi finner ved å trykke på "Analyze > Descriptive Statistics > Explore". Vi får da opp et vindu hvor vi kan velge hvilke variabler vi vil undersøke. Her kan vi flytte bort alle bortsett fra "Person". Videre trykker vi på "Plots" for å velge hvilke visuelle fremstillinger vi ønsker. Her kan vi krysse av for "Histogram" og fjerne "Stem-and-leaf". Etter vi har trykket på "Continue", kan vi velge "Plots" på bunnen av vinduet for å ikke få opp mer informasjon enn vi trenger i dette eksempelet. Valgene våre vil da se omtrent slik ut.

Etter vi har trykket på "OK" får vi opp resultatene våre. Disse består av en tabell under "Case Processing Summary" som forteller oss litt om hvor mange observasjoner som har blitt analysert og om det var noen tomme celler. Lenger nede finner vi histogrammene og boksplottene vi vil se på. Dersom du ikke har tilgang til SPSS, kan du bruke vår Histogramgenerator. Under vises et eksempel fra variabelen "Høyde". I histogrammet (den øverste figuren) får vi en visuell oversikt over hvor mange datapunkter (frekvens) som finnes av hver verdi (høyde). Her kan vi se at de fleste deltakerne våre var rundt 175 cm høye, mens det var færre og færre observasjoner jo nærmere vi kom "ekstremverdiene" på 165 cm og 190 cm. Dette gir oss en kurvet figur som er høyest på midten og lavest på kantene, noe som indikerer at dataene kan være normalfordelte. For å forsikre oss om dette ville vi også undersøkt dataene med statistiske metoder for testing av normalfordeling. Som i scatter-plotten vi lagde tidligere, blir det også her tydelig dersom det finnes noen verdier i datasettet som skiller seg merkbart ut fra den typiske rangen.

Den nederste figuren er en box-plot som viser oss verdiene våre som kvartiler (en kvartil utgjør 25% eller 1/4 av datamaterialet). Feilfeltene over over under er de øverste og laveste kvartilene, mens de midterste kvartilene (25% - 75%) ligger i de blå feltene rundt den tykke streken som viser medianen i datasettet. Vi ser igjen at de fleste verdiene befinner seg innenfor 165 cm og 185 cm, mens hovedvekten av datasettet er sentrert rundt 175 cm. I tillegg ser vi her noen datapunkter som befinner seg utenfor feilfeltet øverst. Dette er ekstremverdier og vises til oss slik at vi kan finne de og vurdere om de bare er uteliggere, eller om de er plottefeil. Tallene ved siden av punktene indikerer nummeret i datasettet, i vårt tilfelle tallet under "Person". Dette gjør det lett for oss å finne observasjonen i datasettet for en eventuell korrigering eller sletting.

Ved å bruke disse verktøyene, gjerne sammen med deskriptiv statistikk, har vi oppnådd en bedre kjennskap til datamaterialet vårt og vi har fått muligheten til å endre eller fjerne uteliggere. Nå har vi en generell formening om hvordan tallene våre er spredt, og vi er rimelig sikre på at datasettet bare inneholder reelle verdier. Dette er et godt grunnlag for å gå videre på våre første statistiske analyser.

Intro til analyser

I dette steget skal vi se på hvordan man bruker SPSS til å gjøre analyser. De fleste ting man gjør i SPSS utføres på lignende måter, bortsett fra at man trykker på forskjellige knapper. For en enkel illustrasjon vil vi her gjennomføre en korrelasjonsanalyse av treningserfaring og muskeltykkelse i Ark 3 i øvingsdatasettet. For å introdusere noen flere elementer i eksempelet, vil vi gjennomføre analysen på hver gruppe separat. Du kan finne en gjennomgang av hvordan man tester dette under Korrelasjon, mens her vil vi bare fokusere på selve fremgangsmåten. Vi skal også undersøke endringen fra pre- til post-test og må derfor lage en ny variabel.

Vi starter i hovedvinduet til SPSS hvor vi kan se datasettet vårt og en verktøylinje øverst. Alle analyser vi gjennomfører i SPSS starter med å trykke på en av disse knappene. Man ville som regel begynt med å bli kjent med datasettet og gjennomført deskriptive analyser, men her antar vi at dette er gjort og vi kan sette igang med analysene.

Siden vi her ønsker å analysere hver gruppe separat, trenger vi å splitte datasettet. For å gjøre dette går vi på "Data > Split File" og får opp et vindu hvor vi kan velge hvordan vi ønsker å splitte datasettet. Når vi først kommer til vinduet, vil denne stå innstilt på "Analyze all cases, do not create groups". For å splitte datasettet krysser vi i stedet av for "Organize output by groups" og flytter den variabelen vi ønsker å basere splittingen på inn i ruten til høyre. Vinduet vil i dette eksempelet se slik ut.

For å gå videre, trykker vi på "OK". Så lenge vi ikke endrer denne innstillingen tilbake, vil alle fremtidige analyser automatisk gjennomføres 3 ganger - en gang for hver gruppe.

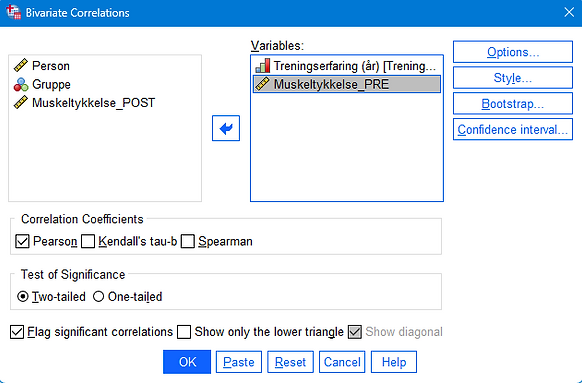

For å kjøre korrelasjonsanalysen, går vi nå på "Analyze > Correlate > Bivariate" og får opp et vindu hvor vi kan velge hvilke variabler vi vil undersøke. De aller fleste analyser starter ved å tykke på "Analyze" og vinduene vi får opp ser omtrent like ut, men med noen forskjeller i hvilke valg vi må ta før vi går videre. I dette eksempelet flytter vi "Treningserfaring" og "Muskeltykkelse_PRE" over i ruten til høyre siden det er disse vi ønsker å analysere. I dette eksempelet trenger vi ikke å gjøre noe mer, men som man ser på bildet nedenfor har man muligheten til å krysse av for ulike valg under, samt å trykke på for eksempel "Options" til høyre for å be om mer eller mindre informasjon av programmet. I andre, mer komplekse analyser, vil det ofte være nødvendig å gå innom "Options" eller "Statistics" for å få den outputen man ønsker. Dette kan du lese mer om på sidene til de spesifikke testene.

Når vi trykker på "OK" kjøres analysen. Da vil vi få opp et nytt vindu (Output) hvor resultatene vises. For dette eksempelet vil vinduet se ut slik som vist i bildet under. Dette vinduet vil se omtrent slik ut uavhengig av hvilken analyse vi har kjørt, men mengden og typen informasjon vil variere. I fanen til venstre finner man en oversikt hvor man enkelt kan bla til den informasjonen man ønsker å hente ut. Dette er spesielt ny spesielt nyttig i større analyser hvor vi får mye informasjon å scrolle gjennom. I hovedvinduet finner vi resultatene. For dette eksempelet finner vi en korrelasjonsanalyse for muskeltykkelse og treningserfaring (du kan lese mer om hvordan man tolker denne outputen under Korrelasjon). I tillegg ser vi her at analysen har blitt kjørt 3 ganger, for gruppe 1, 2 og 3 siden vi valgte å splitte datasettet før vi kjørte analysen. Dersom vi ikke hadde splittet datasettet, ville vi bare fått opp én analyse for hele utvalget.

For det neste steget i eksempelet, vil vi se på endringen fra pre- til post-test. En typisk tilnærming da er å undersøke to ting: hva var den faktiske endringen, og var den var statistisk signifikant. For å svare på første del av spørsmålet trenger vi en oversikt over endringen. I datasettet har vi bare pre- og post-verdiene, så vi trenger å generere en variabel som viser oss endringen. I motsetning til analysene som nesten alltid begynner ved å trykke på "Analyze", skal vi her gå via "Transform > Compute Variable".

I vinduet som dukker opp får vi muligheten til å generere en ny kolonne med data. Dette er et av de få tilfellene i grunnleggende statistikk hvor i faktisk trenger litt matematikkunskaper da vi må be SPSS om å regne ut endringen ved å gi programmet en formel å bruke. Heldigvis er denne utregningen veldig enkel. Vi starter med å gi den nye variabelen et navn. Her kan vi gå på "Target Variable" og skrive inn "Endring_Muskeltykkelse". SPSS er ikke glad i mellomrom, derfor legger vi inn en understrek (_) mellom ordene. Vi går videre i "Numeric Expression" og legger inn formelen for den nye variabelen. Siden vi skal finne ut forskjellen (endringen) mellom pre- og post-test, tar vi variabelen "Muskeltykkelse_POST" bort i ruten til høyre, skriver inn minus (-), og flytter til slutt variabelen "Muskeltykkelse_PRE" bort i ruten. Da vil variabelen bli forskjellen i resultater mellom pre- og post-test. Vinduet vårt vil til slutt se slik ut og når vi trykker på "OK" dukker det opp en ny kolonne til høyre i datasettet vårt som vi når kan analysere.

For å finne ut hva endringen til de tre gruppene var, kan vi i det neste steget trykke på "Analyze > Descriptive Statistics > Descriptives". Her kan vi flytte den nye variabelen bort i ruten til høyre og trykke på "OK" for å få en oversikt over blant annet gjennomsnitt og standardavvik for variabelen. Siden vi enda ikke har fjernet splittingen av datasettet, får vi opp informasjonen for gruppene hver for seg. Dersom vi hadde ønsker mer informasjon, som for eksempel varians, standardfeil eller fordeling, kunne vi ha trykket på "Options" og krysset av for disse før vi trykket på "OK".

Vi kan se at tallene for gjennomsnitt er noe annet enn null, noe som forteller oss at det kan se ut som det var endring mellom de to måletidspunktene. Likevel må vi undersøke om denne endringen var statistisk signifikant. I dette eksempelet skal vi altså sammenligne to måletidspunkter og kan derfor bruke en enkel t-test. For å finne denne, går vi på "Analyze > Compare Means > Paired-Samples T test". Vi velger paired-samples fordi vi har to avhengige grupper. Altså at verdiene for post-test forventes å henge sammen med verdiene på pre-test siden vi undersøker de samme personene to ganger. Vi flytter så "Muskeltykkelse_POST" bort under "Variable1" og "Muskeltykkelse_PRE" under "Variable2". Vi må legge variablene i denne rekkefølgen for å få riktige tall. Dersom vi flytter pre før post, vil t-testen fortsatt bli riktig, men vil analysere en endring fra post- til pre-test heller enn motsatt. Etter at vi har flyttet variablene bort, trykker vi på "OK" for å kjøre analysen. I outputen kan vi hente ut p-verdiene for endringene til de 3 gruppene under kolonnen som heter "Sig. (2-tailed)". Vi finner at alle har en p-verdi under 0.05, noe som forteller oss at alle gruppene hadde en statistisk signifikant endring fra pre- til post-test.

Ved å bare se på tallene, kan vi observere at gjennomsnittene for de 3 gruppene ikke er identiske. Dette betyr ikke nødvendigvis at det er en statistisk signifikant forskjell mellom gruppene. For å undersøke dette, ville vi kjørt en analyse av varians (ANOVA). Når vi ønsker å gjøre analyser på hele datasette (som for eksempel å sammenligne grupper) er det viktig å huske å fjerne splittingen av datasettet (noe som er lett å glemme). I dette eksempelet vil vi ikke gå gjennom ANOVA, men du kan lese mer om denne testen her, mens under finner du mer informasjon om hvorfor vi trenger en ANOVA heller enn å gjennomføre 3 individuelle t-tester for å sammenligne gruppene.

Diverse

I denne seksjonen kan du finne generelle tips og informasjon som er nyttig når man jobber med statistikk i SPSS. Seksjonen vil oppdateres underveis basert på innsendte spørsmål eller kommentarer. Du kan sende inn dine egne spørsmål under Kontakt.

P-verdier

P-verdien er et sentralt begrep i statistiske analyser som hjelper forskere å forstå om observasjoner er statistisk signifikante eller ikke. Enkelt fortalt sier p-verdien oss sannsynligheten for å observere dataene våre gitt at nullhypotesen er sann. Nullhypotesen representerer vanligvis en situasjon der det ikke er noen effekt eller forskjell, og vår målsetting er ofte å teste gyldigheten av denne hypotesen.

La oss bruke et eksempel: Tenk deg at en forsker ønsker å finne ut om en ny type gjødsel fører til bedre vekst i planter sammenlignet med standard gjødsel. Forskeren planter to grupper av identiske frø: en gruppe med den nye gjødselen og en kontrollgruppe med standard gjødsel. Etter noen uker måler forskeren veksten i begge gruppene. Når forskeren analyserer resultatene, beregner de en p-verdi basert på vekstdifferansen mellom de to gruppene. La oss si at p-verdien beregnes til p = 0.03. Dette betyr at det er en 3% sannsynlighet for å observere denne mengden av vekstforskjell eller mer, hvis den nye gjødselen faktisk ikke hadde noen effekt (nullhypotesen). Med andre ord, en p-verdi på 0,03 antyder at det er lite sannsynlig at resultatene skyldes tilfeldigheter alene, slik at forskeren kan være rimelig sikker på at den nye gjødselen har en reell effekt.

Tradisjonelt har forskere brukt en terskelverdi på 0.05 for p-verdien for å avgjøre om resultatene er statistisk signifikante. Hvis p-verdien er mindre enn 0.05 (som den var i vårt eksempel), avviser de nullhypotesen og konkluderer med at det er statistisk signifikant bevis for en forskjell eller effekt. En avkrefting av null-hypotesen vil altså alltid samsvare med en bekreftelse av hypotesen. Hvis p-verdien er større enn 0.05, konkluderer de med at det ikke er nok bevis for å avvise nullhypotesen. Det er imidlertid viktig å huske på at p-verdien alene ikke gir informasjon om størrelsen på effekten eller dens praktiske betydning. En lav p-verdi indikerer bare at forskjellen eller effekten er usannsynlig å skyldes tilfeldighet, men sier ingenting om hvor stor eller viktig denne effekten er i praksis. Derfor bør p-verdier alltid tolkes i konteksten av studiens design, størrelsen på effekten, og relevansen for det større forskningsfeltet.

Effekstørrelse

Når forskere utfører statistiske tester, er det ikke nok å bare vite om en effekt eller forskjell er statistisk signifikant; det er også viktig å forstå hvor stor elelr betydningsfull denne effekten er. Effektstørrelser gir en kvantitativ måling av styrken på en effekt eller forskjell, uavhengig av prøvestørrelsen i studien. Dette gjør det mulig for forskere å vurdere den praktiske betydningen av forskningsfunn med mer dybde enn en p-verdi alene kan gi.

To vanlige mål for effektstørrelse i sammenligninger av to grupper eller måletidspunkt er Cohen's d og Hedges' g. Begge målene uttrykker effektstørrelsen som antall standardavvik forskjellen mellom gruppene utgjør. Cohen's d er et direkte mål på effektstørrelsen som beregnes ved å trekke gjennomsnittet av en gruppe fra gjennomsnittet av en annen gruppe og deretter dele på det samlede standardavviket fra begge gruppene. Cohen's d er spesielt nyttig for å måle størrelsen på en effekt når man sammenligner to grupper. Hedges' g er en justert versjon av Cohen's d som tar hensyn til små eller ulike prøvestørrelser, noe som gjør det mer nøyaktig for studier med færre deltakere. Hedges' g bruker en korreksjonsfaktor for å korrigere bias som oppstår i estimatet av standardavviket i små prøver. Valget mellom Cohen's d og Hedges' g avhenger ofte av prøvestørrelsen i studien. For større studier med prøvestørrelser over 20 per gruppe, vil forskjellen mellom de to være minimal. I slike tilfeller kan Cohen's d være en enklere og tilstrekkelig tilnærming. For mindre studier anbefales det å bruke Hedges' g for å korrigere for bias som følge av små prøvestørrelser. Du kan lese mer om effekstørrelser og beregne Cohen's d eller Hedges' g for dine egne data på denne siden.

Hvorfor bruke ANOVA for å sammenligne 3 eller flere grupper

Som nevnt over, bør man heller gjennomføre ANOVA (eller andre tester som kan sammenligne flere grupper i samme test) enn flere t-tester når man har mer enn 2 grupper eller måletidspunker. Sammenlignet med å utføre flere t-tester, gir ANOVA en mer robust og effektiv metode for å analysere forskjeller mellom tre eller flere grupper. Den kontrollerer risikoen for Type I-feil og gir en helhetlig forståelse av variansen i dataene. Når signifikante forskjeller er identifisert, tillater post-hoc tester oss å utforske disse forskjellene ytterligere, og dermed oppnå en grundig forståelse av dynamikken mellom gruppene.

Kontroll over Type I-feil

Når man utfører flere t-tester for å sammenligne gruppene parvis, øker risikoen for å gjøre en Type I-feil. Det vil si å feilaktig avvise nullhypotesen når den faktisk er sann. Dette skyldes at hver t-test har en bestemt sannsynlighet (5%) for å produsere en Type I-feil, og ved å utføre flere tester, akkumuleres denne risikoen (15% dersom vi kjører 3 t-tester og 100% hvis vi kjører 20 t-tester). ANOVA kontrollerer for denne risikoen ved å analysere variansen mellom alle gruppene samtidig, dermed opprettholdes den overordnede sannsynligheten for å gjøre en Type I-feil på det ønskede nivået (5%).

Effektivitet

ANOVA tillater å teste hypoteser om gruppegjennomsnittene i ett enkelt statistisk rammeverk, noe som gjør det mer effektivt enn å utføre flere individuelle tester. Dette sparer både tid og ressurser, samtidig som det gir et mer strømlinjeformet og lettfattelig resultatsett.

Varians

En annen fordel med ANOVA er dens evne til å skille mellom variasjonen som skyldes eksperimentelle effekter og variasjon som skyldes tilfeldigheter (innenfor-gruppevarians). Ved å analysere den totale variansen kan ANOVA hjelpe forskere med å forstå bedre hvilken del av variansen som kan forklares av behandlingen eller tilstanden som studeres, i motsetning til variasjon som oppstår naturlig innen hver gruppe.

Post-hoc tester

Selv om ANOVA er effektiv for å avgjøre om det finnes signifikante forskjeller mellom tre eller flere grupper, spesifiserer den ikke hvilke spesifikke grupper som er forskjellige fra hverandre. Derfor, når ANOVA indikerer en signifikant forskjell, er neste skritt å utføre post hoc-tester. Disse testene er designet for å gjøre parvise sammenligninger mellom gruppene for å identifisere hvor de signifikante forskjellene ligger. Post-hoc tester, som Tukey's Honestly Significant Difference (HSD) test eller Bonferroni-korreksjonen, tar hensyn til det økte antallet sammenligninger for å kontrollere for Type I-feilrisiko. Enkelt fortalt er post- hoc tester det samme som t-tester, men de er strengere for å opprettholde påliteligheten ved flere sammenligninger. Jo flere sammenligninger man har (grupper eller måletidspunkt), jo strengere vil post-hoc testene være for å opprettholde kravet om 5% feilmargin.